クローラビリティとは?SEOとの関係と改善方法を解説

Google検索エンジンの検索結果にページを表示するためには、そのページがGoogleBot(グーグルボット)にクロールされる必要があります。

そこで重要になるのが、クローラビリティ(Crawlability)という概念です。クローラビリティの向上を図ることで、検索エンジンの検索結果に掲載されるページ数やスピードが高まっていきます。

今回は、クローラビリティについて解説します。クローラビリティの概要や仕組みのほか、クロール頻度を高めるためのポイントをご紹介していきます。

今回は、クローラビリティについて解説します。クローラビリティの概要や仕組みのほか、クロール頻度を高めるためのポイントをご紹介していきます。

クローラビリティとは

クローラビリティ(Crawlability)とは、クローラーがWEBページを見つけて巡回しやすい状態かを示すSEO用語です。

一般的に、ここでいうクローラーとは、Google検索エンジンで利用されているGoogleBot(グーグルボット)と呼ばれるロボットを指します。

新規ページを作成したら、GoogleBotに巡回されてページ評価が下されます。そのうえで、一定以上の価値があると判断されたらGoogle検索エンジンに登録されます。

クローラビリティとSEOの関係

クローラビリティを向上させることで、WEBサイト内のページがクロールされやすくなります。結果として、Google検索エンジンに登録されるスピードとページ数が増えていきます。SEOでは、こうした実績の積み重ねが大切ですので、クローラビリティはSEO施策の1つに位置付けられます。

逆に、どれだけ高品質のコンテンツを作っても、GoogleBotに認識してもらわないとインデックされることはありませんので注意してください。

GoogleBotがクロールする仕組み

GoogleBot(グーグルボット)は、常に世界中のWEBを巡回して新規ページや既存ページをクロールし続けています。GoogleBotは、主に下記のような経路で巡回しています。

- インデックスページのリンクを辿る

- クロール申請の情報を参照する

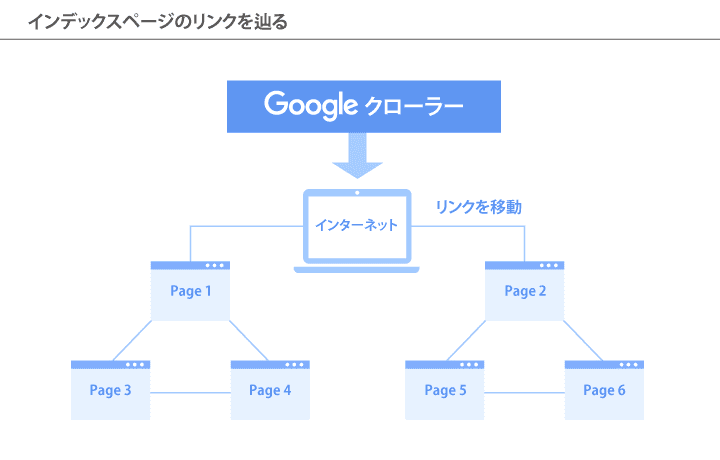

インデックスページのリンクを辿る

基本的には、WEBページ間で結ばれたリンクがGoogleBotの巡回ルートとして利用されています。

そもそも、Google検索エンジンの検索結果にページを掲載するためには、Google検索エンジンに登録する必要があります。そして、検索エンジンのデータベースにページが登録されることをインデックス(Index)と呼びます。

GoogleBotの巡回ルートになり得るのは、すでにGoogle検索エンジンにインデックス登録されたページのリンクが対象になります。

クロール申請の情報を参照する

Googleにクロール申請を出すと、GoogleBotが対象のURLを認知してクロールできるようになります。クロール申請には、運用しているWEBサイトを解析できる、Google Search Console(グーグルサーチコンソール)というツールが利用されます。

このほかでは、GoogleBotはXMLサイトマップと呼ばれる、サイト上のページとページの関係性を伝えるファイルを参照してクロールすることがあります。

XMLサイトマップをGoogleに送信すると、GoogleBotにWEBサイトの存在が認知されて対象のWEBサイトを巡回できるようになります。

インデックスの確認方法

GoogleBotにページをクロールされると、Google検索エンジンにインデックスされる可能性がでてきます。実際にインデックスされたかどうかは、下記の方法で確認できます。

- site:検索を利用する

- Google Search Consoleで確認する

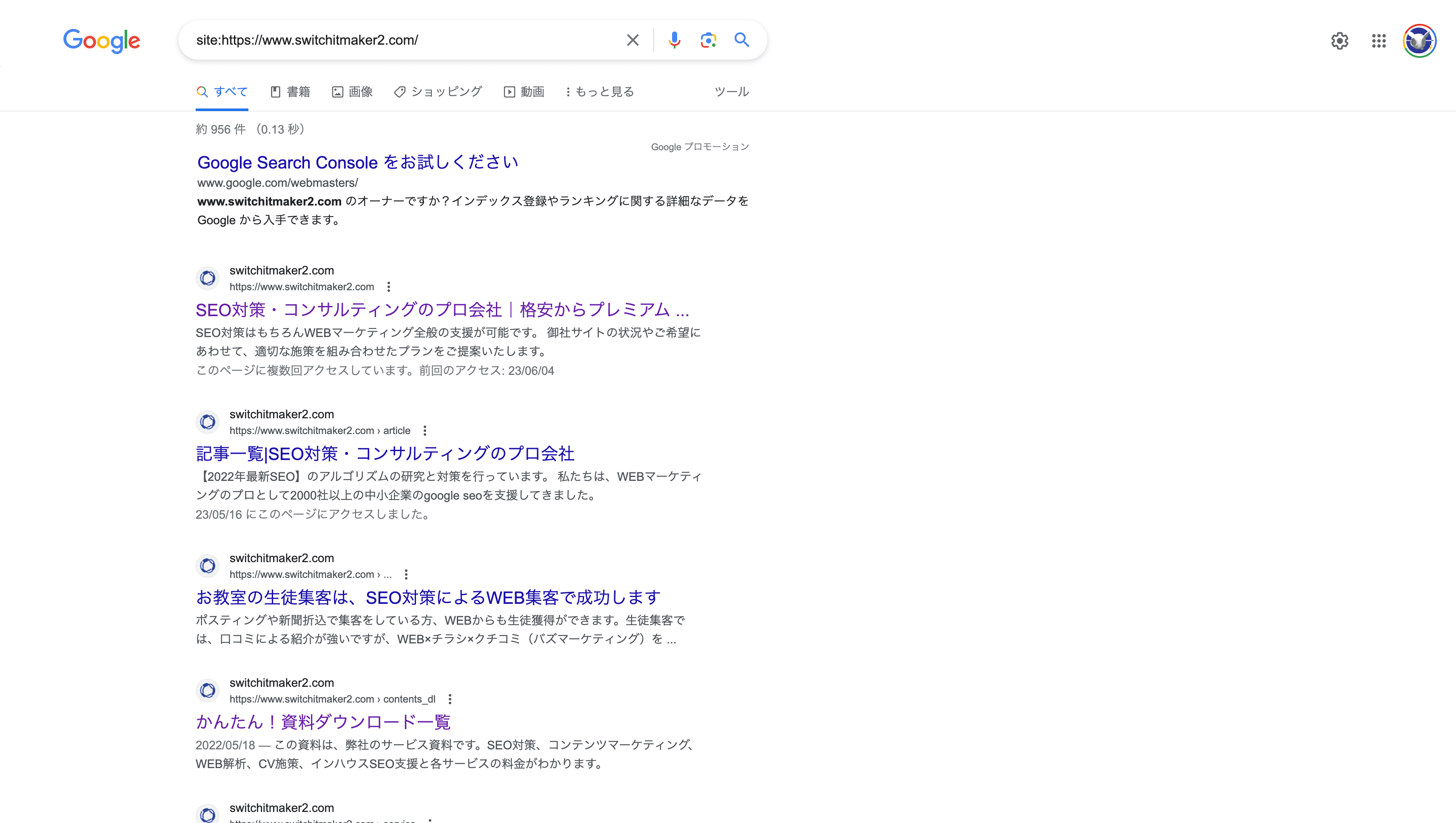

site:検索を利用する

Google検索エンジンの検索ボックスに下記のように調べたいURLを入力すると、該当のページがインデックスされているかわかります。

このときにWEBサイトのドメインをURLとして入力すると、WEBサイトに含まれるページのなかでインデックス済みのものをすべて調べられます。

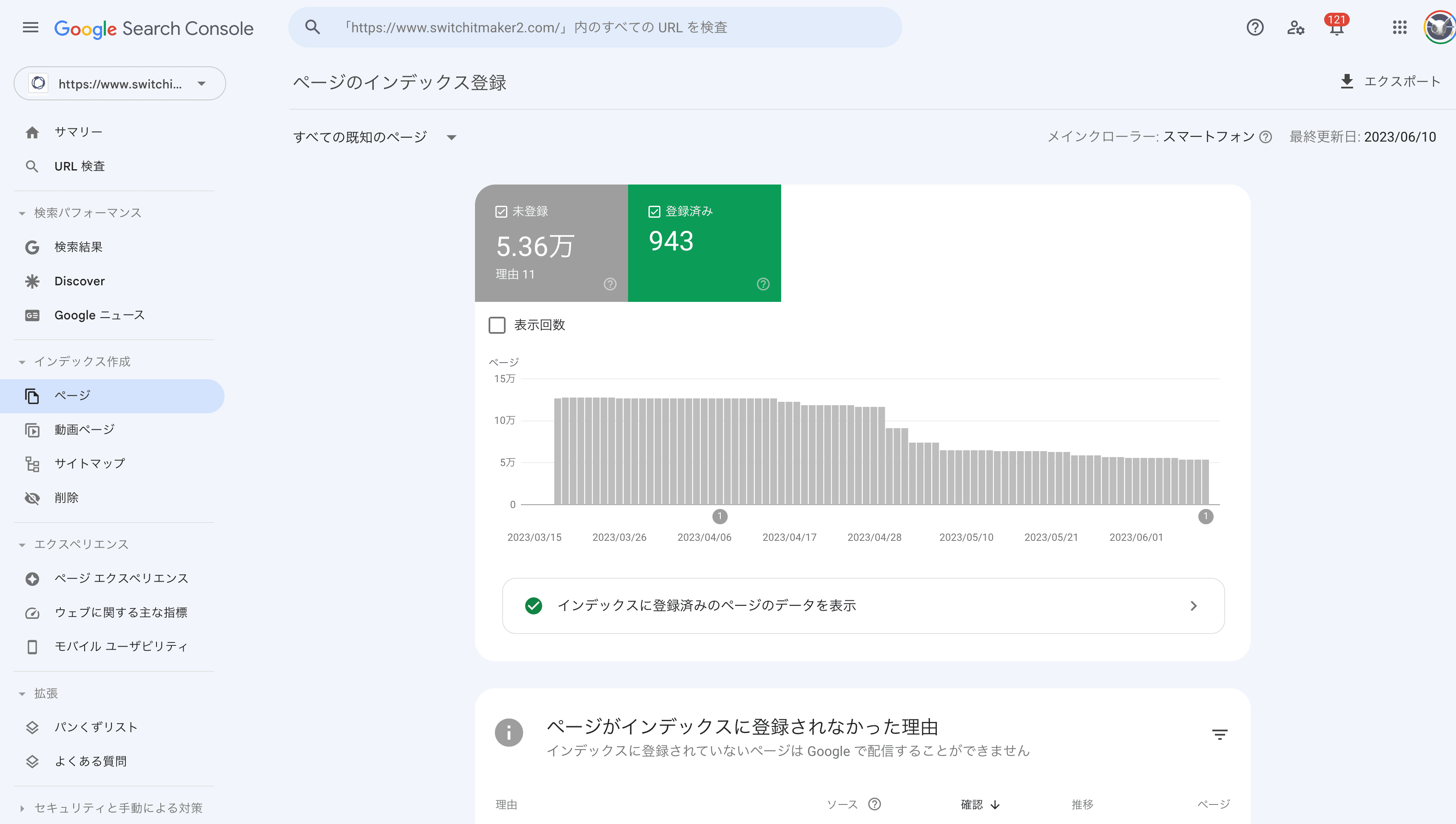

Google Search Consoleで確認する

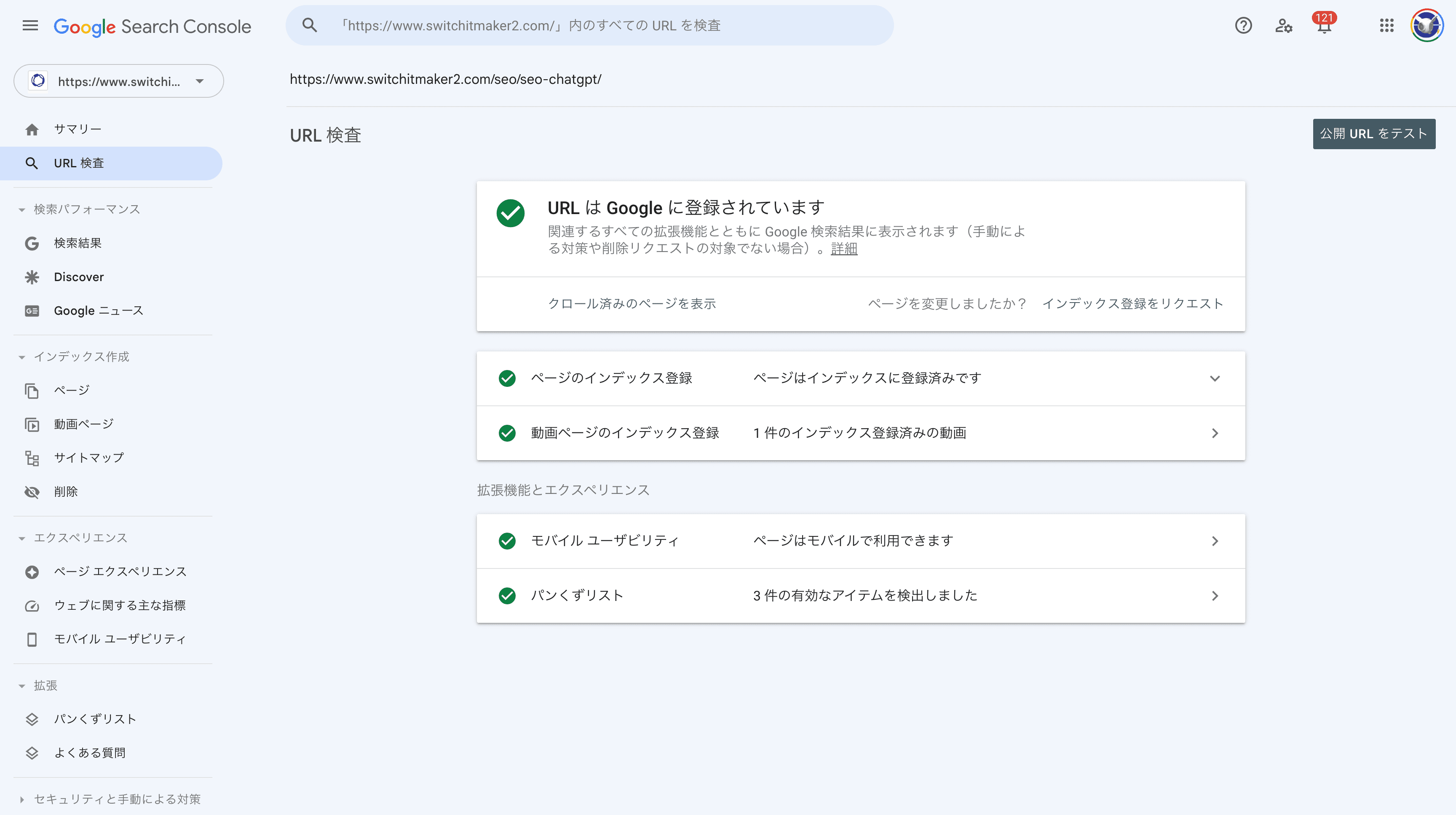

Google Search Consoleを利用してインデックス状況を確認できます。

Google Search Consoleにログインして、メニューの「インデックス作成」から「ページ」を選択してください。すると、WEBサイト内でインデックスされているページ数とURLが表示されます。

とくに新規サイトの場合、記事公開して一定期間が過ぎるとインデックスが進みます。もしも、公開後にインデックスの進みが遅かったり、公開ページ数とインデックスページ数に大きな乖離があった場合、サイトが何かしらの問題を抱えている可能性があります。

Google Search Consoleでは、こうした調査ができますので、WEBサイトを運用するうえでは非常に有用なツールです。まだ利用していない人は、まずはGoogle Search Consoleの導入を検討してください。

クローラビリティを向上させる施策

クローラビリティを向上させる施策としては、下記のような手段があります。

- XMLサイトマップを作成する

- クロールをリクエストする

- txtを設置する

- 内部リンクを設置する

- 被リンクを獲得する

- サイト構成を最適化する

- 孤立ページをなくす

- URL正規化する

- サイトに対するクロール頻度を高める

XMLサイトマップを作成する

XMLサイトマップを作成して送信することで、GoogleBotがWEBサイトを認知して、サイト構造を理解させる手助けになります。GoogleBotがクロールする機会の確保につながりますので、XMLサイトマップの作成を検討してください。サイトマップを作成する場合は、下記のフローで進めてください。

- XMLサイトマップを作成する

- WEBサイトにXMLサイトマップを設置する

- XMLサイトマップをGoogleに送信する

クロールをリクエストする

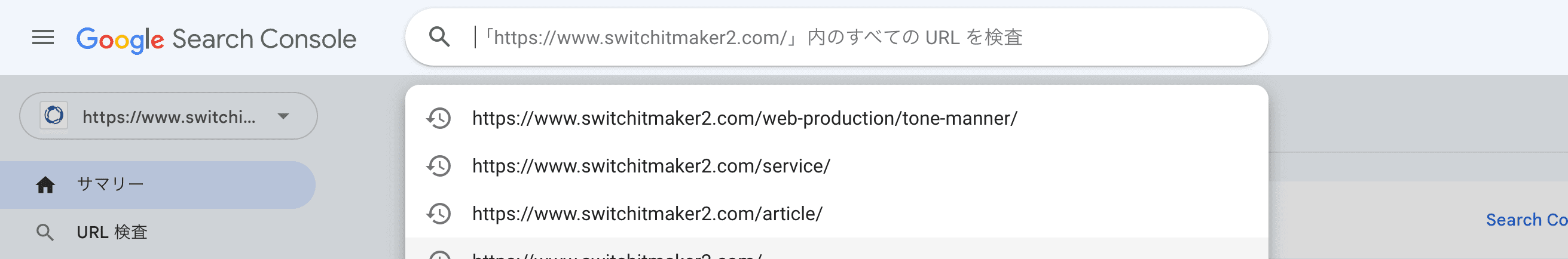

Google Search Consoleを通じて、Googleに対してページ単位でクロールリクエストを出せます。

リクエストを出すためには、Google Search Consoleにログインして、メニューから「URL検査」を選択します。検査ボックスにクロールリクエストを出したいページURLを入力してください。

URL検索の結果が出たら、ページのステータスが表示されます。この画面では、下記のようなことがわかります。

- ページがクロールされたか否か

- ページがインデックスされたか否か

- ページのエクスペリエンス状態

まだクロールされていなければ、クロール申請を出してください。

ただし、これはあくまでクロールを促すための申請です。リクエストを出したからといって、GoogleBotがクロールすることを保証するものではない点に注意してください。

robots.txtを設置する

robots.txtとは、GoogleBotに対して、アクセスしてもよいURLとアクセスを禁止するURLを指定するファイルです。このファイルを利用することで、不要なクロールを避けられますので、クロール効率が高まります。

例えば、robots.txtに対して下記のように記述したとします。

User-agent: Googlebot

Disallow: /nogooglebot/

User-agent: *

Allow: /

Sitemap: https://www.example.com/sitemap.xml

引用:robots.txt の書き方、設定と送信 | Google 検索セントラル

すると、GoogleBotに対して、「https://example.com/nogooglebot/」以下のにあるすべてのURLにクロール制限をかけられます。

内部リンクを設置する

内部リンクを設置することで、クローラーがサイト内の記事をみつけやすくなります。内部リンクには、下記のような種類があります。

- グローバルナビゲーション

- パンくずリスト

- ダイナミックナビゲーション(サイト内検索)

- 関連記事リンク

ただし、内部リンクは、サイト訪問者が探したい情報を見つけやすくすることがメイン目的のコンテンツです。リンクの数を増やすために、無関係のリンクを貼るといった行為は避けてください。

被リンクを獲得する

外部サイトから被リンクを受けると、クローラーが巡回する経路拡大につながります。さらに、品質が高い被リンクが増えると、高いSEO効果も得られます。

被リンク施策としては、下記のようなものが挙げられます。

- 商品紹介メディアと商品サイトの間で相互リンクする

- 自社の企業サイトと商品サイトの間で相互リンクする

被リンクは、あくまで自然に発生するリンクである必要があります。スパム的に被リンクを集める行為は、Googleにペナルティを受ける原因になりますので注意してください。

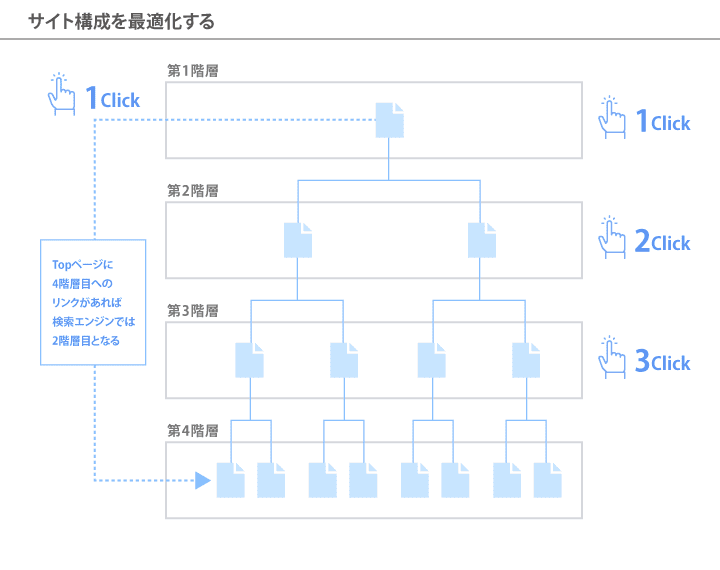

サイト構成を最適化する

わかりやすいサイト構成を構築すると、クローラーが巡回しやすい環境が整います。一般的な目安としては、すべてのページをトップページから3クリック以内で到達できるように設計することが推奨されています。

逆に、サイトの階層を増やしすぎると複雑化しやすくなります。このようなサイト構成になっている場合は、構成のシンプル化を検討してください。

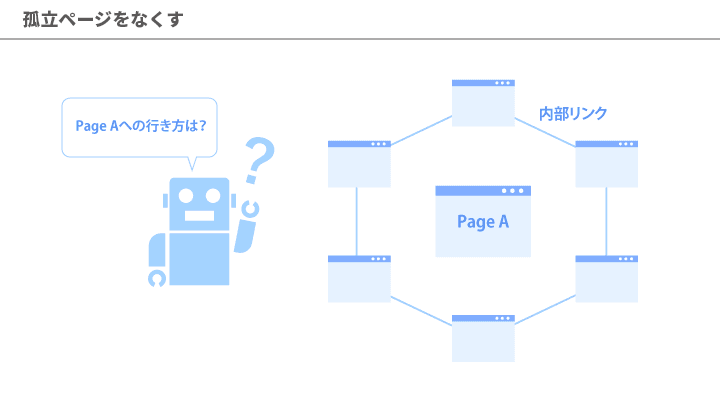

孤立ページをなくす

サイト内のどのページからもリンクされていない孤立したページがあると、クロールされづらくなります。こうしたページが多数あると、「よくわからないサイト構成」と評価されて、SEO面でもマイナス要因となり得ますので注意してください。

対策としては、普段からExcel(エクセル)などのツールを利用してページ管理を徹底するといったことが挙げられます。

URL正規化する

URLを正規化することで、GoogleBotにクロールすべきURLを指定できます。これによって、クロール効率が高まります。

URL正規化とは、サイト内に同じ内容のページが複数ある場合に、正しいURLの表記をGoogleに伝える施策のことです。同じ内容のページがあるというのは、例えば下記のような状況を指します。

- URL末尾の「/」の有無により、同内容ページを2つ生成した

- 「www.」の有無により、同内容ページを2つ生成した

- SSL化の有無により、同内容ページを2つ生成した

URLを正規化するためには、下記の2つの方法があります。

- 301リダイレクト

- カノニカル設定

サイトに対するクロール頻度を高める

WEBサイトには、クロール頻度といった概念があり、クロールされやすいサイトとそうでないサイトが存在します。一般的には、Googleから高評価を得ているサイトのクロール頻度が高まりやすい傾向にあります。

Googleから高評価を得るためには、総合的なサイトの品質が問われます。Googleに評価されるような、価値があり、かつ高品質なコンテンツの作成に努めてください。

クローラビリティのよくある質問

クローラビリティに関する、よくある質問をFAQ形式でまとめています。

Q:クローラビリティの向上施策をしたほうがよいですか?

Answer)集客にSEOを考慮するならば、施策が必要です。

クローラビリティ施策は、インデックスを促進して集客することが目的となります。SEOを考慮する場合は必要な施策となります。

Q:クローラビリティの語源は?

Answer)クロール(Crawl)と能力(Ability)を組み合わせた造語です。

転じて、クローラビリティとは、クローラーによるWEBページの見つけやすさを指します。

Q:クローラビリティの最適化とは?

Answer)ページをクロールされやすくするための施策です。

Google検索エンジンの検索結果に表示させるためには、ページ公開した後にクロールされることが必須です。このクロールを促すために、サイトやページの作りを見直す必要があります。

Q:クローラーの種類は?

Answer)GoogleBot以外にも、様々な種類のクローラーが存在します。

GoogleBotは、あくまでGoogle検索エンジン用のクローラーです。ほかの検索サービスには、それぞれに別のクローラーが用意されています。クローラーの一例を下記にご紹介します。

- Applebot(アップルボット)

- Linespider(ラインスパイダー)

- Bingbot(ビングボット)

まとめ

クローラビリティとは、WEBサイトのクロールしやすさのことです。サイト構成や内部リンクを最適化することで、GoogleBotが巡回しやすいサイトになります。まずは、Google Search Consoleといったツールを利用して、 サイトのクローラビリティを確認してみてください。そのうえで、問題がありそうだったら要因を特定して改善する必要があります。さらに、高品質コンテンツを作り続けることで、クロール頻度が高まっていきます。

クローラビリティとは、WEBサイトのクロールしやすさのことです。サイト構成や内部リンクを最適化することで、GoogleBotが巡回しやすいサイトになります。まずは、Google Search Consoleといったツールを利用して、 サイトのクローラビリティを確認してみてください。そのうえで、問題がありそうだったら要因を特定して改善する必要があります。さらに、高品質コンテンツを作り続けることで、クロール頻度が高まっていきます。